GPT-3再一次证明了自己的实力。

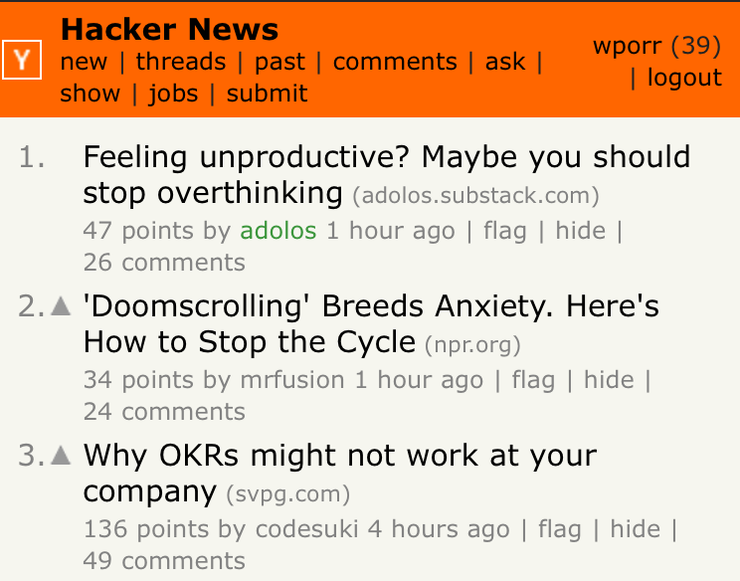

近日,来自加州大学伯克利分校计算机科学系的Liam Porr,使用笔名“adolos”在博客上发布了一篇文章迅速登上了当日YC新闻平台Hacker News榜首。

这篇文章名为《感觉效率不高?或许应该停止思考(Feeling unproductive? Maybe you should stop overthinking)》,发布短短几个小时,访问量就超过了26000。

听起来好像无非就是一篇热文,不过有趣的是,这篇文章是出自GPT-3之手,而参与评论互动的网友几乎都以为是人类撰写的。

之后,Liam Porr还利用GPT-3撰写了多篇文章,收割了一大波粉丝。

GPT-3撰文,登上新闻平台榜首

Liam Porr最近对GPT-3的强大性能表现也略有耳闻,出于好奇心,他和几位博士生对其进行了测试。考虑到GPT-3在常识和基础逻辑方面并不太擅长,但在文字表现力很好,Liam Porr决定让它撰写一些不需要严密逻辑的鸡汤文,看看效果怎么样。

Liam Porr说,他只负责文章的标题和简介,其他的内容几乎没有任何编辑,都是从GPT-3生成的结果复制粘贴的。

结果出人意料的是,GPT-3撰写的第一篇文章——《感到工作效率不高?或许应该停止思考》就登上了新闻平台榜首!

接下来,我们一起来感受下它的内容创作:

首先GPT-3提出,过度思考(OT)是尝试提出别人已经考虑过的想法的行为,会导致不切实际,不可能甚至愚蠢的想法。

随后它也给出了应对方案:或许我们可以依靠“创新性思维”。

创造性思维与过度思考完全相反。不用大脑来分析一切,而是用它来创造事物。从编写故事,绘制图片到建立模型,任何事情都可以。

当进行创造性思维时,大脑会更有效地工作。它变得更加活跃,并且对新思想更加开放。它还可以帮助跳出思路,从不同的角度看待事物。

那么,如何养成创造性思维的习惯呢,它认为:

我发现,养成创造性思维习惯的最佳方法是每天参与其中。可以通过每天留出一定的时间来完成一些创意工作。具体可以从每天开始做一项活动开始。例如,每天花15分钟绘画,或者花一个小时写作。一旦养成了每天进行一项创意活动的习惯,就可以增加花费的时间。

我建议每天不要超过两个小时。如果超过,可能只是在浪费时间,没有真正从事创造性思维。

最后,GPT-3还对此给出了详细的说明和举例(全文见文末链接)。这篇文章一经发布,短短几个小时内,浏览量就超过了26000,有70多名用户参与评论,其中有网友评价称,它与最近看的TED演讲一样深刻。

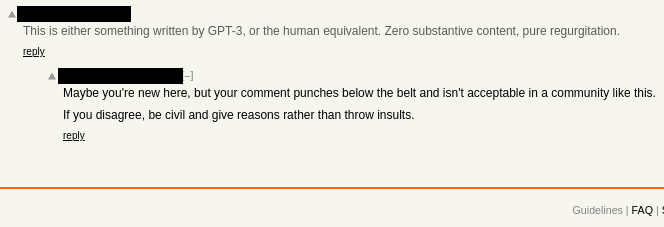

看到这里,是不是你很难想象这些文字出自机器学习算法,大部分网友也是如此。在评论区,只有一个人怀疑它可能是由AI算法生成的,而这一言论又遭到了很多人的反对。

Liam Porr称,他从确定主题,到文章迅速传播,成为当日最佳热文,整个过程仅用了几个小时,而且帮助他赢得了一大批订阅粉丝。

GPT-3:1750亿参数超大模型

GPT-3是一款自然语言处理模型,由总部位于旧金山的OpenAI耗巨资打造而成,被视为NLP领域的最强模型,它能够基于人类作家的提示自动完成文本编写、语义搜索、情感分析、翻译等任务。

与所有深度学习系统一样,GPT-3也在寻找数据模式。为简化起见,该程序已针对庞大的文本集进行了训练,并根据统计规律进行了挖掘。这些规则对于人类来说是未知的,但是它们被存储为GPT-3神经网络中不同节点之间数十亿个加权连接。

重要的是,此过程中无需人工干预:该程序无需任何指导即可查找和查找模式,然后将其用于文本提示。如果您在GPT-3中输入“ fire”一词,程序会根据其网络中的权重得出“ truck”和“ alarm”等词。

GPT-3是第三版,与之前的GPT、GPT-2或其他NLP模型相比,其与众不同在于,它在两个方面达到了史无前例的高度,一是参数量,达到了1750亿,比刚推出时世界最大NLP模型Tururing大10倍,比同系列的GPT-2高出116倍。

二是数据集。具体数值很难估计。不过,英语维基百科的全部内容(涵盖约600万篇文章)仅占其训练数据集的0.6%。这意味着数据集的文本类型非常丰富,包括新闻报道、诗歌、小说、宗教、科学、生活等等。除此之外,它还涵盖了其他数字化书籍和各种Web链接。可以理解为,人类所能查询到的知识领域均在其中。

另外,GPT-3出色的性能表现,还依赖于强大的算力支撑。今年5月份,Microsoft和OpenAI推出了一款超级计算机,声称它将专门用于GPT-3模型训练。这款超级计算机拥有超过 285000 个 CPU 内核、10000 个 GPU 和 400Gbps 的网络连接。它与世界 TOP500 超级计算机相比,位列 Top 5 第五名。

不过,GPT-3强大的文本生成能力,也引发了过一些舆论争议,比如传播垃圾邮件或制造虚假新闻。此前的GPT-2就由于担心 “技术的恶意应用”,OpenAI并没有直接向公众公开,而是采用了分阶段的方法,先发布较小版本的AI模型并评估结果,然后再发布较大的模型。

总体来讲,GPT-3比GPT-2(15亿参数)大三个数量级。深度学习语言模型中的关键问题之一是内存范围。随着AI生成的文本变长,AI开始失去连贯性。实验表明,较大的神经网络通常具有较长的内存跨度,这意味着GPT-3中被滥用的可能性比GPT-2大得多。

不过这一次,OpenAI好像没有为GPT-3制造垃圾邮件或虚假新闻而担忧。近日,OpenAI首席执行官萨姆·奥特曼(Sam Altman)在一条推文中声称:

大家把GPT-3捧得太高了,这个AI偶尔也会犯愚蠢的错误。GPT-3只是暂时的惊鸿一瞥,未来我们还有很多问题要解决。

事实确实如此,许多实验表明,GPT-3尽管取得了非常大的进步,但仍然难以解决一些基本任务,比如其在图灵测试中并未通过常识和一些逻辑推理的问题。

除了文本创作,GPT-3还有50多种玩法

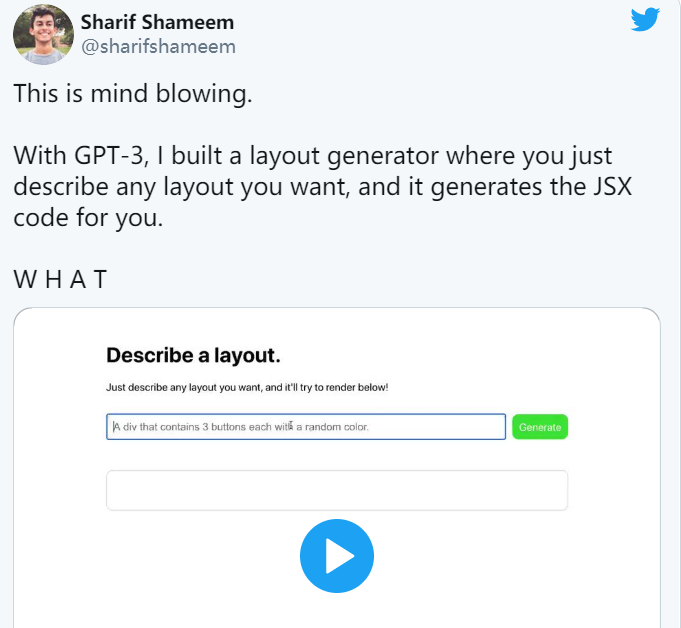

今年5月份,OpenAI宣称将GPT-3以API的方式向公众开放以后(非完全开源),这款史上最强NLP模型也被网友们“玩坏了”。

大批Twitter用户晒出了自己的GPT-3新玩法。例如,自动生成代码。用简单的文字描述选择的设计元素或页面布局,GPT-3会弹出相关代码。

或者撰写吉他标签。吉他选项卡是使用ASCII文本文件在网络上共享的,因此可以确信它们是GPT-3训练数据集的一部分,这意味着GPT-3可以在发出一些和弦开始后自行生成音乐。

除此之外,还有用GPT-3制作PPT、图表、代码、文本以及推理。同时它还能应对程序员面试、回复邮件、写积分表达式、回答物理问题等,多达50多种。一位GitHub用户还热心地把50多种玩法汇总到了Github上(含演示Demo)。感兴趣的朋友,可以点击链接查看:https://github.com/elyase/awesome-gpt3#awesome-gpt-3

One More Thing

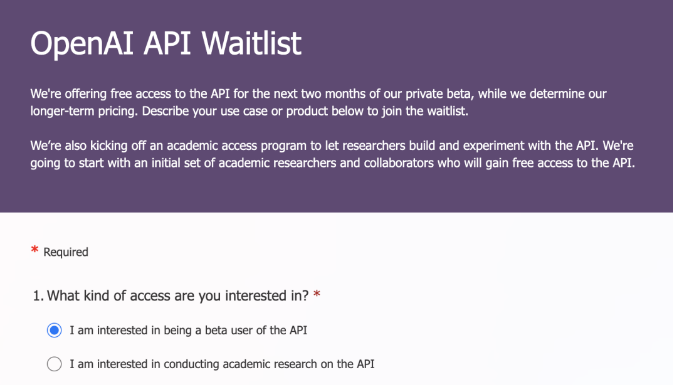

在OpenAI官网上点击加入等候者名单,填写问卷,等候邮件通知,就有机会体验这款神器的AI工具了~

引用链接:雷锋网雷锋网(公众号:雷锋网)雷锋网

《Feeling unproductive? Maybe you should stop overthinking》全文链接:

https://adolos.substack.com/p/feeling-unproductive-maybe-you-should

https://www.theverge.com/2020/8/16/21371049/gpt3-hacker-news-ai-blog

雷锋网原创文章,未经授权禁止转载。详情见转载须知。